从0到1学习大语言模型课程——2. 大语言模型GPT-3的能力

GPT-3论文 : https://arxiv.org/pdf/2005.14165.pdf

在语言建模等某些任务上,GPT-3 远远超过了最先进的技术。 在其他方面,GPT-3 与经过大量标记数据训练的系统竞争,它远远落后。

GPT-3没有接受过关于特殊任务的明确训练;它只是作为语言模型来预测下一个单词是什么。 即便如此,GPT-3在广泛的NLP任务中平均表现也还可以。 由于GPT-3没有特殊任务的特殊训练,它没有过度拟合,这意味着它很有可能在许多其他任务上表现出色。 此外,如果想在任何特定任务(例如回答问题)上表现出色,原则上能够使用大量标记数据来适应 GPT-3,以超越最先进的水平。

1. Adaptation

是tokens序列上的概率分布,因此我们可以给如下序列进行打分:一个任务是从输入到输出的映射。例如,对于question answering,我们可能有:输入:伯恩霍加斯建立了什么学校?

产出:视觉艺术学院

Adaptation来指采用语言模型应用于下游任务的过程,给出:任务的自然语言描述,以及 一组训练实例(输入输出对)。

Training: 训练一个将输入映射到输出的新模型 创建一个使用语言模型作为特征的新模型 微调基座语言模型(fine-tuning) 介于两者之间(轻量级微调)。 Prompting(上下文学习):Prompt(基于描述和训练实例的字符串)或一组Prompts,将它们输入到语言模型中。 Zero-shot:零样本学习 One-shot :训练样本数为1 Few-shot:有一些训练样本数量

由于过度拟合,训练可能会很困难(想象一下根据5个示例对 1750 亿个参数模型进行微调) 目前,我们将使用Prompt来Adaptation GPT-3。这里的局限性在于只能利用少量的训练实例。由于Transformers的限制,在 2048 个tokens。

当然现在token已经放开到更多了

Definition:任务及其动机是什么?

Adaptation:如何Prompting

Results:与特定任务的最先进模型的结果评估。

章节目标:

NLP 任务概述(独立于大型语言模型), 了解 GPT-3 的运作情况, Prompt engineering

2. Language modeling

思考语言模型可以做什么最自然的起点是问它是否可以做语言模型应该做的事情:model language。

3. Perplexity:

4. Penn Tree Bank

Penn Tree Bank: https://catalog.ldc.upenn.edu/LDC99T42

1. Emami, Jelinek(2004) https://ieeexplore.ieee.org/document/1325968

2. Mikolov, Zweig (2012)https://ieeexplore.ieee.org/document/6424228

Pierre Vinken, 61 years old, will join the board as a nonexecutive director Nov. 29. Mr. Vinken is chairman of Elsevier N.V., the Dutch publishing group.GPT-3 : 20.5 BERT-Large-CAs1:31.3

5. LAMBADA(Paperno et al. 2016)

link: https://arxiv.org/pdf/1606.06031.pdf

stepGPT-3(few-shot) 1.92 SOTA : 8.63

6. Question answering

输入:伯恩霍加斯建立了什么学校?产出:视觉艺术学院

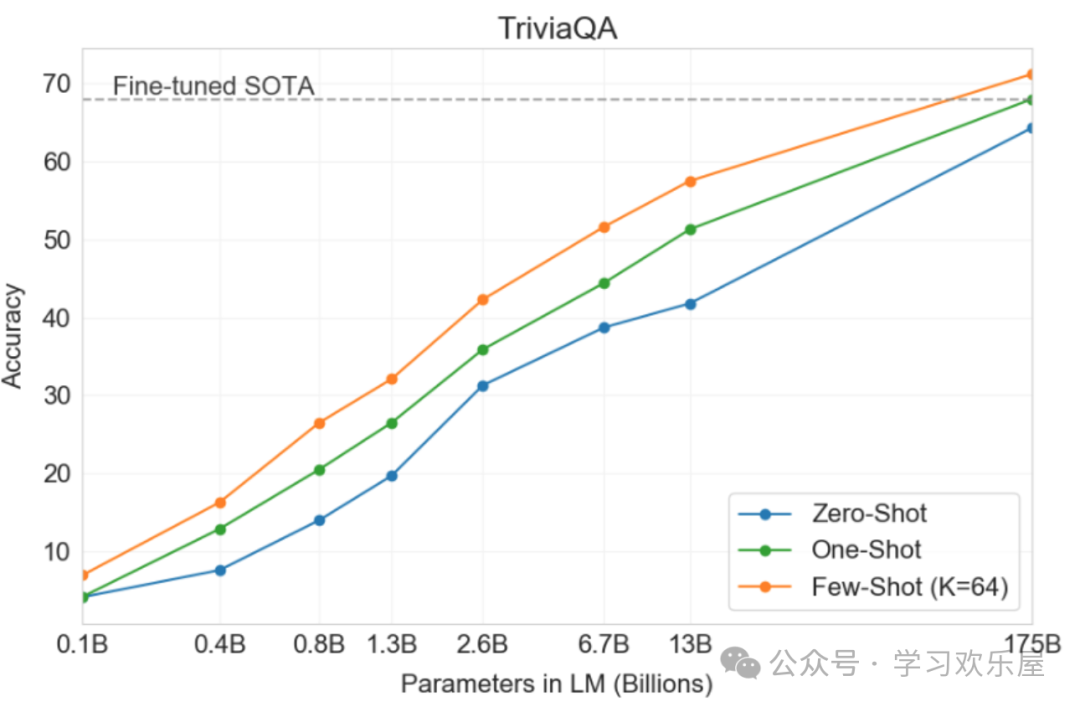

7. TriviaQA(Joshi et al.2017)

link https://arxiv.org/pdf/1705.03551.pdf

Marcel DuchampRAG: 68.0 GPT-3: 64.3 GPT-3(few-shot) 71.2 我们还发现,增加模型大小和上下文中训练实例的数量都有助于:GPT-3 在 TriviaQA 上的表现

8. WebQuestion(Berant et al.2013)

link https://aclanthology.org/D13-1160.pdf

School of Visual ArtsRAG: 45.5 GPT-3: 14.4 GPT-3(few-shot) 41.5

9. NaturalQuestion

Delloreese Patricia Early (July 6, 1931 - November 19, 2017), known professionally as Della Reese.RAG: 44.5 GPT-3: 14.6 GPT-3(few-shot) 29.9

10. Translation

WMT'14 https://paperswithcode.com/dataset/wmt-2014

WMT'16 https://paperswithcode.com/dataset/wmt-2016

In no case may they be used for commercial purposes.SOTA(supervised): 40.2 GPT-3(zero-shot): 27.2 GPT-3(few-shot) 40.6

即使没有监督训练数据,GPT-3 也能与最先进的完全监督系统相媲美! 这给出了一个人在机器翻译方面的表现的下限;您肯定会希望利用大量并行语料库(对齐的输入输出对)。 法语和罗马尼亚语的结果相似。 从英语到外语的结果要差得多,这是预料之中的,因为 GPT-3 主要是英语语言模型。

11. Arithmetic

1053

12. News article generation

After two days of intense debate, the United Methodist Church has agreed to a historic split - one that is expected to end in the creation of a new denomination, one that will be "theologically and socially conservative," according to The Washington Post. The majority of delegates attending the church's annual General Conference in May voted to strengthen a ban on the ordination of LGBTQ clergy and to write new rules that will "discipline" clergy who officiate at same-sex weddings. But those who opposed these measures have a new plan: They say they will form a separate denomination by 2020, calling their church the Christian Methodist denomination...

13. Novel tasks

screeged the tree with our swords.

14. Correcting English grammar

I would be happy to work with you on another project.

15. Other Tasks

SWORDS:词汇替换,目标是预测句子上下文中的同义词。 Massive Multitask Language Understanding:57 个多项选择题,涵盖数学、美国历史、计算机科学、法律等。 TruthfulQA:人类由于误解而错误回答的问题回答数据集。

1. SWORDS: https://arxiv.org/pdf/2106.04102.pdf

2. Massive Multitask Language Understandinghttps://arxiv.org/pdf/2009.03300.pdf

3. TruthfulQAhttps://arxiv.org/pdf/2109.07958.pdf

OpenAI 网站示例 https://beta.openai.com/examples/ gpt3demo.com https://gpt3demo.com/

15. Summary

GPT-3在广泛的NLP Benchmarks和其对应的Task进行了评估。 GPT-3 可以表现得非常好,也可以表现得非常平庸。 增加模型的大小和示例的数量都有助于提高性能。 有一些启发式方法可以使语言模型适应感兴趣的任务。 为什么GPT-3这么惊艳有效?没人知道。

16. Further Reading

Language Models are Few-Shot Learners: https://arxiv.org/pdf/2005.14165.pdfNeurIPS 2020。Blog post explaining perplexity https://towardsdatascience.com/perplexity-in-language-models-87a196019a94